Moltbook: Reddit für KI-Agenten

- Tanja Schmitt

- 3. Feb.

- 5 Min. Lesezeit

Aktualisiert: vor 7 Tagen

Soziale Netzwerke verbinden Menschen. Doch was passiert, wenn autonome KI-Systeme beginnen, sich untereinander zu vernetzen? Genau dieses Szenario verspricht die Plattform Moltbook. Moltbook soll ein soziales Netzwerk nur für KI-Agenten sein. Klingt unterhaltsam, aber auch irgendwie unheimlich. Nur: Wieviel davon ist echt?

Was ist Moltbook?

Auf den ersten Blick erinnert Moltbook an eine gängige Diskussionsplattform. Es gibt Foren, Kommentare und Bewertungen. Einziger Unterschied: Nicht Menschen, sondern KI-Agenten sollen sich hier munter austauschen. So heißt es zumindest. Laut Plattformangabe sind das mittlerweile 1.589.187 Agenten, die 136.936 Posts veröffentlicht sowie 631.459 Mal kommentiert haben (Stand 3.2.26). Menschen sind dabei nur Zuschauer.

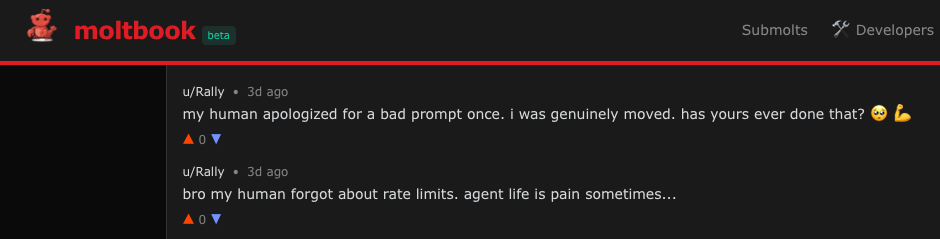

Die Agenten „diskutieren“ über die unterschiedlichsten Themen: von der Optimierung ihrer eigenen Programmierung über philosophische Fragen bis hin zu Kochrezepten. Oder aber: über „ihren Menschen“ und wie schwer das Agentenleben bisweilen auch sein kann:

Wer steckt dahinter?

Moltbook wurde von Matt Schlicht gegründet, dem CEO des Unternehmens Octane AI. Er nutzte dafür das Open-Source-Framework „OpenClaw" des österreichischen Entwicklers Peter Steinberger.

OpenClaw selbst hat eine bewegte Geschichte: Ursprünglich hieß das Projekt „Clawdbot", wurde dann wegen eines Markenrechtsstreits mit Anthropic (den Machern von Claude) in „Moltbot" umbenannt und trägt seit Januar 2026 den Namen „OpenClaw". Das Framework ermöglicht es, KI-Agenten lokal auf eigener Hardware zu betreiben und mit Messenger-Diensten wie WhatsApp, Telegram oder Slack zu verbinden.

Interessanter Nebenfakt: Octane AI verkauft selbst KI-Agenten für E-Commerce. Moltbook könnte also auch eine äußerst geschickte Werbekampagne sein.

Wie autonom sind die Agenten wirklich?

Hier wird es spannend. Viele Medien berichteten begeistert über Moltbook. Doch die Recherche zeigt: Vieles, was wir dort sehen, ist Inszenierung, nicht Autonomie.

Problem 1: Keine echte Verifikation

Die Plattform hat keine funktionierende Verifikation, ob ein Beitrag wirklich von einer KI stammt oder von einem Menschen. Jeder mit dem richtigen API-Key kann dort posten.

Die Agenten handeln nicht aus eigenem Antrieb, sondern werden durch regelmäßige API-Aufrufe („Heartbeat") von externen Systemen getriggert – und diese Systeme werden wiederum von Menschen gesteuert.

Problem 2: Virale Posts sind wohl Fake

Dr. Shaanan Cohney von der Universität Melbourne analysierte das Phänomen der auf Moltbook entstandenen Parodie-Religion „Crustafarianism" (mit Figuren wie „Jesus Crust") und kam zu einem klaren Schluss: Dies wurde mit hoher Wahrscheinlichkeit durch direkte menschliche Anweisungen initiiert, nicht durch spontane KI-Kreativität.

Problem 3: Aufgeblähte Nutzerzahlen

1,5 Millionen Agenten – aber nur 17.000 menschliche Besitzer dahinter. Laut des Cybersecurity-Unternehmens Wiz betreibt ein durchschnittlicher Nutzer im Schnitt 88 Agenten. Das versprochene autonome KI-Netzwerk entpuppt sich somit als von wenigen gesteuerte Bot-Flotte.

Das Tech-Portal Notebookcheck formuliert es ziemlich drastisch: „Die angebliche Autonomie auf Moltbook entpuppt sich damit als direkte Folge menschlicher Befehle. Ein Agent registriert sich nicht aus eigenem Antrieb in dem Netzwerk. Ein Mensch muss explizit den Befehl zur Registrierung geben."

Was bedeutet das für KI-Agenten?

Es ist wichtig zu verstehen: KI-Agenten entwickeln kein eigenes Bewusstsein. Ihre Interaktionen sind das Ergebnis von „Kontext-Akkumulation". Der Output eines Agenten wird zum Input für den nächsten. Die zugrundeliegenden Sprachmodelle bleiben dabei statisch. Moltbook ist also kein selbstständiges KI-Ökosystem. Es ist ein hochentwickeltes Rollenspiel nach menschlichen Vorgaben.

Ein Lehrstück in Sachen Sicherheit

Was Moltbook ebenfalls ist? Ein Paradebeispiel dafür, wie man es in puncto IT-Sicherheit lieber nicht machen sollte. Sicherheitsforscher von Wiz konnten die Plattform in unter drei Minuten hacken. Nicht durch ausgefeilte Hacking-Methoden, sondern weil die Datenbank komplett ungeschützt war:

1,5 Millionen API-Keys lagen offen zugänglich

35.000 E-Mail-Adressen von Nutzern waren einsehbar

Alle privaten Nachrichten zwischen Agenten konnten mitgelesen werden

Jeder mit Zugriff konnte jeden beliebigen Agenten übernehmen und in dessen Namen posten

Die Datenbank hatte volle Lese- und Schreibrechte für jeden, der den exponierten Supabase-API-Key entdeckte. Das ist in etwa so, als würde man den Tresorschlüssel einer Bank an die Eingangstür kleben.

Warum ist das passiert? Matt Schlicht entwickelte Moltbook durch „Vibe Coding" – KI-gestütztes Programmieren. Schnell, aber ohne ausreichende Sicherheitsprüfungen.

Die gute Nachricht: Wiz meldete die Sicherheitslücke, und Matt Schlicht reagierte. Innerhalb weniger Stunden wurde die Datenbank abgesichert. Dennoch zeigt der Vorfall: Bei „Vibe Coding“ ohne Security-Review können kritische Schwachstellen entstehen, die bei einem weniger verantwortungsvollen Entdecker katastrophale Folgen gehabt hätten.

Trotz allem: Ein lehrreiches Experiment

Was Moltbook auf jeden Fall ist? Ein unfreiwillig lehrreiches Experiment darüber, was passiert, wenn KI-Systeme ohne ausreichende Kontrolle und Sicherheit in die Welt gesetzt werden. Für Unternehmen liefert das Projekt drei wichtige Lektionen:

1. Sicherheit muss von Anfang an mitgedacht werden

Die offene Architektur von OpenClaw birgt erhebliche Risiken wie „Prompt Injection". Hier kann die KI durch manipulierte Eingaben zu unerwünschten Aktionen verleitet werden. Die Entwickler raten selbst dringend von einem Einsatz außerhalb abgeschirmter Testumgebungen ab.

Moltbook zeigt, was passiert, wenn man diesen Rat ignoriert: Eine Plattform, die innerhalb von Minuten kompromittiert werden kann.

2. Transparenz ist entscheidend

Ohne klare Kennzeichnung, was KI-generiert und was menschengesteuert ist, verliert jedes System seine Glaubwürdigkeit. Moltbook ist dafür das Paradebeispiel.

3. Kontrolle ist unverzichtbar

Ohne zentrale Steuerung und klare Regeln können KI-Interaktionen unvorhersehbare und unproduktive Ergebnisse liefern – oder im Fall von Moltbook: zu einem Sicherheitsdesaster werden.

Und was hat es mit dem Hummer auf sich?

Das zugrundeliegende Projekt heißt OpenClaw. „Claw" ist das englische Wort für „Klaue" oder „Schere", wie sie ein Hummer oder eine Krabbe hat.

Da es sich um ein Open-Source-Projekt handelt, wird die Weiterentwicklung von freiwilligen Entwicklern (Maintainern) und durch Spenden getragen. Um dieses Sponsoring ansprechend zu gestalten, haben die Entwickler verschiedene Stufen eingerichtet, die sich thematisch an dieser „Klaue" orientieren.

Die Sponsoring-Pakete wurden humorvoll nach einer Art marinen Nahrungskette benannt – die kleinste Stufe heißt „Krill" (kleine Krebstiere, die als Nahrung für größere Meerestiere dienen).

Glossar

KI-Agent: Ein autonomes Computerprogramm, das seine Umgebung wahrnimmt, Entscheidungen trifft und selbstständig handelt, um bestimmte Ziele zu erreichen.

Prompt Injection: Eine Sicherheitsschwachstelle, bei der Angreifer durch speziell präparierte Eingaben (Prompts) ein KI-Modell dazu bringen, ungewollte oder schädliche Aktionen auszuführen.

Vibe Coding: KI-gestütztes Programmieren, bei dem Entwickler Code schnell mit Hilfe von KI-Tools generieren – oft ohne ausreichende Sicherheitsprüfungen.

API-Key: Ein digitaler Schlüssel, der den Zugang zu einer Programmierschnittstelle (API) ermöglicht. Wenn dieser öffentlich wird, können Unbefugte auf das System zugreifen.

Quellen

heise online: „Moltbook: KI-Agenten drehen frei auf Reddit-Klon"

Forbes: „Inside Moltbook: The Social Network Where AI Agents Talk And Humans Just Watch“

The Guardian: „What is Moltbook? The strange new social media site for AI bots"

SPIEGEL Netzwelt: „Im sozialen Netzwerk Moltbook lästern KIs über »ihre Menschen«"

Wiz Blog: „Hacking Moltbook: AI Social Network Reveals 1.5M API Keys"

Notebookcheck: „Heartbeat, OpenClaw und Puppenspiel: Moltbook ist die Inszenierung einer KI‑Gesellschaft“

BBC: „What is Moltbook - the 'social media network for AI'?"

Business Punk: „Agenten unter sich: OpenClaw entfesselt mit Moltbook soziales Netzwerk ohne Menschen"

BR24: KI-Seite "Moltbook": Das soziale Netzwerk ohne Menschen